Vers un Web des IA [Partie 1] : Des LLM aux agents IA

De l’IA au concept d’agent : raisonner, mémoriser et agir

5/5/20254 min read

4. L’émergence de l’Agent IA

Cette capacité à raisonner et agir pose les bases de l’agent IA. Mais un agent, pour être complet, a besoin d’une mémoire : les LLM n'ont aucune mémoire native entre deux appels.

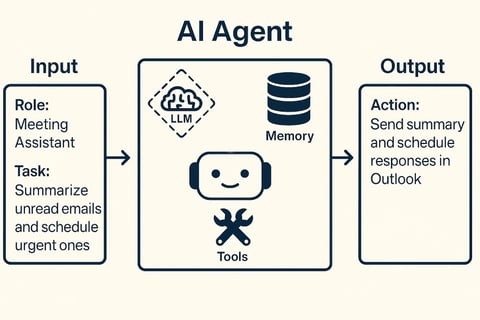

Pour véritablement parler d’un agent IA complet, trois éléments essentiels doivent être réunis :

Un LLM : qui sert de centre de raisonnement, guidé par des objectifs clairs et des rôles définis.

Une boucle d'outils (function calling) : permettant au modèle d’interagir avec son environnement pour réaliser des actions.

Une mémoire externe : indispensable pour assurer une continuité et permettre à l’agent de mémoriser ses interactions précédentes. En pratique, cela consiste à injecter dans chaque appel l'historique de l'interaction afin de simuler une forme de continuité dans l'interaction.

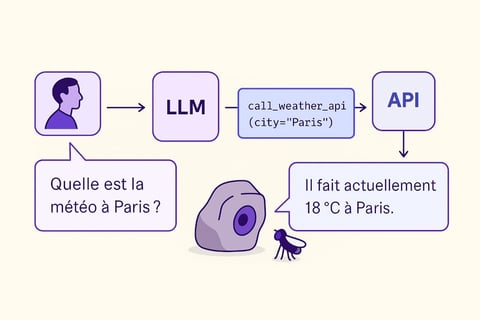

Prenons un exemple concret : un utilisateur interroge une application IA. Celle-ci fait appel à un LLM. Le LLM raisonne et décide d'appeler un outil ce qui revient à procéder à un appel de fonction. L’outil est exécuté, la réponse de la fonction est renvoyée au LLM, avec l’historique de l'interaction. Le LLM peut alors produire une réponse contextualisée et pertinente.

1. Introduction

Dans le premier article, nous avons exploré comment l’IA générative dépasse largement le cadre d’une simple tendance technologique. Intéressons-nous maintenant à la transformation des grands modèles de langage (LLM) en véritables agents IA, capables non seulement de raisonner mais aussi d’agir et de mémoriser.

2. Des modèles fondationnels aux modèles instruct

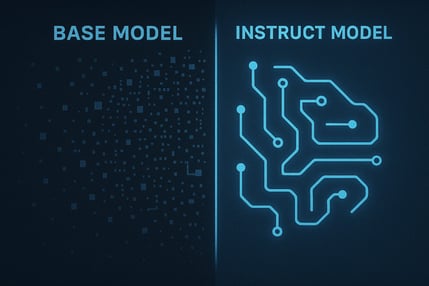

Tout commence avec les modèles dits « fondationnels », entraînés sur d’immenses corpus de données textuelles et capables de stocker d'énormes volumes de connaissances générales. Malgré cette richesse, ces modèles ne sont pas immédiatement adaptés à une interaction directe avec les utilisateurs.

C’est ici que l'affinage (fine-tuning + RLHF) intervient pour transformer ces modèles de base en modèles instruct (2022). Ces derniers peuvent suivre des instructions précises et interagir efficacement avec l’utilisateur. Ils se déclinent principalement en deux formats :

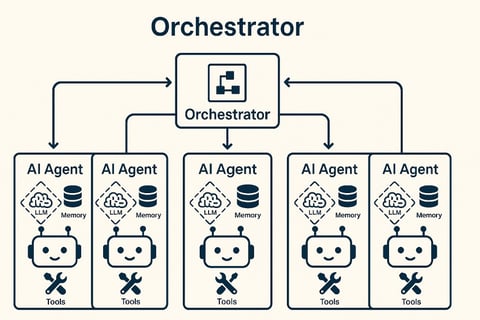

5. Systèmes multi-agents : coopération et orchestration

L'étape suivante consiste à déléguer des tâches spécifiques (ex. extraction d’informations, synthèse, vérification, etc.) à différents agents IA capables de coopérer pour résoudre des problèmes complexes.

Un orchestrateur intervient alors pour planifier, répartir les tâches et coordonner les interactions entre ces agents spécialisés. Chaque agent traite une tâche spécifique et renvoie ses résultats à l'agent principal.

On parle alors de système multi-agent, une architecture distribuée où les compétences sont mutualisées, la résolution de problèmes devient collective.

Dans la prochaine partie, nous détaillerons comment le protocole MCP permet de créer un Web structuré et interopérable spécialement conçu pour faciliter l’interaction entre agents IA.

3. Le Function Calling : vers l’action autonome

Une étape essentielle vers la création d’agents IA a été franchie en juin 2023 avec l’apparition du function calling. Cette fonctionnalité permet au modèle de générer des appels structurés vers des fonctions externes, incluant les paramètres nécessaires à leur exécution. Dit autrement, cette propriété permet au LLM d'interagir avec un environnement de développement.

Par exemple, lorsqu’un utilisateur demande « Quelle est la météo à Paris ? », le modèle seul ne peut pas connaître la réponse actuelle. Cependant, grâce au function calling, le modèle LLM peut appeler automatiquement une API météo, récupérer la donnée pertinente et répondre de manière précise.

Le modèle devient ainsi interactif : il ne se contente plus de raisonner, il agit en interagissant avec du code. Le niveau d'interaction définira le niveau d'agentivité de l'application IA et en particulier de l'agent correspondant.

Complétion : Le modèle génère la suite la plus probable à partir d’un prompt donné.

Chat : Le modèle dialogue en tenant compte de rôles clairement définis (système, utilisateur, assistant).

Le format « chat » est rapidement devenu dominant car il permet un meilleur encadrement du comportement du modèle et facilite l’injection de données contextuelles ou externes grâce à des techniques comme le RAG (Retrieval-Augmented Generation).